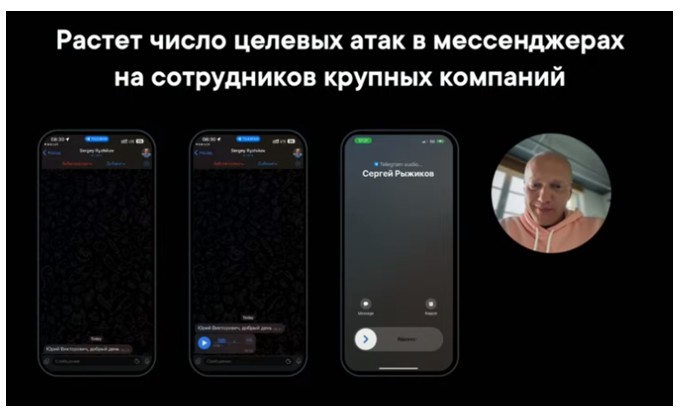

Искусственный интеллект в мошеннических схемах. Атаки на сотрудников крупных компаний

Мы самостоятельно предоставляем мошенникам все данные для фальсификации, размещая публикации в социальных сетях – свои фото, видео, голос, где кушаем, чем увлекаемся, с кем дружим, куда ходим и т.п.

Необходимо не реагировать на такие провокации, а сразу связываться напрямую с тем человеком, кто обращался к вам, для уточнения информации, а лучше сразу с несколькими ответственными людьми компании, кто отвечает за данную сферу, в которой было сформировано требование.

Примеры использования

1. Клонирование голосаПервые отчеты о применении технологии ИИ в схемах обмана по телефону западные эксперты начали получать с 2022 года.

Благодаря имеющимся уже технологиям хакерам достаточно всего лишь 20-секундного фрагмента с разговором, взятым из социальной сети, видео и аудиозаписей для создания клона голоса любого человека. Поэтому выбирают мошенники в первую очередь публичных людей.. Идентичность поражает настолько, что даже мать не сможет отличить голос своего ребенка от робота.

Схема обмана та же, но инструменты более прогрессивные. ИИ звонит и просит перевести деньги. Преступники заставляют жертв думать, что они разговаривают с родственником, которому вдруг понадобились деньги, например, на возмещение ущерба в результате ДТП.

Сейчас нейросеть можно обучить языкам, и она с легкостью осваивает любые акценты, чтобы умело вести диалог. «Нужно срочно расплатиться! Вот номер продавца, скинь ему деньги» – теперь сможет услышать ни о чем не подозревающий человек на том конце провода.

"Например, приходит сообщение от начальника, который говорит, что сейчас с ним свяжутся правоохранительные органы. Затем идёт уже всем нам знакомая тема с социальной инженерией — жертву заставляют верить в действительность происходящего, и она отдаёт преступникам деньги".

Следует не вестись на эмоции, а сразу перезвонить своим родным, знакомым, коллегам от которых вы якобы получили срочную или тревожную просьбу. А еще лучше придумайте кодовое слово, для своих. Прямо как в банке. И таким образом, вы будете знать, что звонят действительно родные и близкие, а не мошенники с нейросетью.

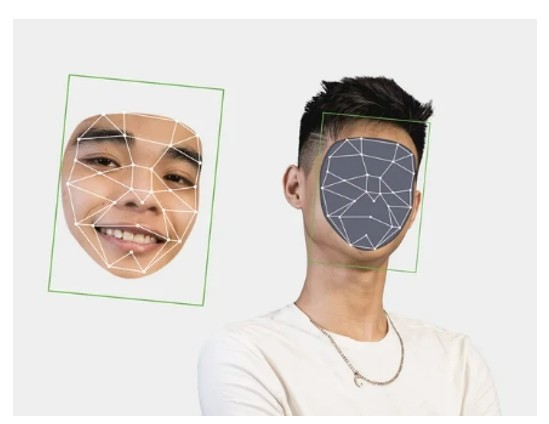

2. Имитация образа

Подделать можно не только голос, но и образ. При помощи методики синтеза медиаконтента, основанной на искусственном интеллекте, удается наложить ненастоящие изображение или видео на реальные. Технология именуется «дипфейк» (от англ. deepfake – «подделка»).

Если ранее созданные видеоклоны выдавали свою искусственность темпом речи, асинхронностью и неестественными эмоциями, то в настоящее время с ростом уровня ИИ, искусственность становится уже малозаметной.

Источники обращений

1. С неизвестных источниковОбращения с неизвестных номеров, аккаунтов должны вызывать по умолчанию опасения, даже если слышим знакомый голос или видим знакомое лицо.

2. С известных источников

Сначала преступники получают доступ к аккаунту, затем начинают писать потенциальным жертвам из числа списка контактов его владельца с просьбой перевести деньги и другой информации. Историю о необходимости помощи преступники подкрепляют голосовым или видео сообщением якобы от лица владельца аккаунта.

В арсенале злоумышленников имеется немало способов применения нейросетей в целях мошенничества.

Это могут быть как подделка документов и голосовые дипфейки (подделка голоса), так и организация сбора средств якобы на благотворительные цели, шантаж с использованием поддельных видео- и фотодокументов, а также фишинговые рассылки для сбора личных данных.

Искусственный интеллект научился хорошо справляться с созданием документов. Так, нейросети способны достаточно быстро генерировать поддельные паспорта, водительские удостоверения и банковские выписки.

Да что говорить о фальсификации документов, когда нейросеть может скопировать даже личность конкретного человека, проанализировав его стиль письма в соцсетях, и это тоже нередко используется для совершения мошенничества!

Например, основываясь на этих данных, нейросеть может написать письмо вашим родственникам и сообщить, что вы якобы попали в сложную ситуацию – для решения проблемы вам срочно требуются деньги. Кроме того, в целях совершения мошенничества может быть клонирован ваш голос – для этого используется технология синтеза реча (deep voice technology).

При совместном использовании этих двух инструментов злоумышленники способны создать запись вашего голоса, который будет говорить еще и вашими фразами. Например, известны случаи мошенничества, когда родители получали аудиозапись с голосом ребенка, который рассказывал, что его похитили и необходимо внести выкуп.

Еще один пример использования нейросетей в целях мошенничества – кража тридцати пяти миллионов долларов у управляющего банка. Ему позвонил один из постоянных клиентов и сообщил, что его компания намерена совершить транзакцию на 35 млн рублей. В подтверждение этих слов банкиру пришло на электронную почту письмо с аналогичной просьбой и указанием реквизитов.

Управляющий подтвердил запрошенную транзакцию, а спустя некоторое время выяснилось, что и звонок, и письмо были поддельными и не имели отношения к данному клиенту, а банкир стал жертвой мошенничества.

«Нейросети набирают популярность во всем мире. А еще быстрее они становятся популярными среди мошенников. И тут все достаточно просто. Первая причина – современные нейросети устроены так, что не нужно быть программистом, чтобы работать с ними. Эта простота привлекает мошенников». Второй же причиной является то, что нейросети показывают стабильно хороший результат, исключающий фактор человеческий ошибки, а третья причина – высокая скорость работы. Все это вместе взятое создает практически неограниченные возможности для использования нейросетей в целях мошенничества.

Рекомендации

Ниже представлены несколько рекомендаций, с помощью которых можно значительно уменьшить риск стать жертвой мошенничества с помощью искусственного интеллекта.- защита аккаунтов – необходимо везде, где это возможно, подключить двухфакторную идентификацию;

- обеспечение безопасности профиля в социальных сетях – следует закрыть доступ посторонним к личной информации на страницах соцсетей, сделав их приватными;

- установка спам-защиты от нежелательных звонков – в этом случае вы сразу увидите, кто вам звонит. По возможности, чтобы не стать жертвой мошенничества, не стоит отвечать на звонки с незнакомых номеров. Кроме того, если вы в разговоре почувствовали что-то неладное, лучше всего будет задать собеседнику случайный вопрос – это поможет понять, что вы общаетесь с живым человеком, а не с ботом.

- нужно быть острожным при вводе личной информации на веб-сайтах и не открывать подозрительные электронные письма.

- в социальных сетях нельзя давать никакой личной информации незнакомым людям. Это может стать ключиком для дальнейшего удачного обмана.

- если в ходе общения в мессенджере бот или робот предлагает ввести личную финансовую информацию (коды из смс от банка, полные данные карты, ФИО, паспортные данные и т. д.) необходимо прервать общение, обратиться в отделение банка либо самостоятельно связаться с организацией по контактам, которые указаны на официальном сайте компании.

- лично проверять всю информацию, поступающую от друзей, родственников, коллег в соцсетях и мессенджерах. То есть, если подруга вдруг попросила денег, чтобы оплатить посылку, лучше перезвонить и услышать просьбу в разговоре.

- если вы решили самостоятельно воспользоваться услугами нейросети, убедитесь, что действительно оказались на официальном ресурсе. Не переходите по сомнительным ссылкам, предлагающим ввести данные для оплаты, и не устанавливайте на свои устройства неизвестные приложения. Злоумышленники начали создавать фишинговые ресурсы, маскируя их под сервисы, позволяющие купить доступ к чат-боту на базе искусственного интеллекта (ИИ) ChatGPT.

Дмитрий Иванков

эксперт Центра искусственного интеллекта СКБ Контур

«ИИ в кибепреступности использовался и раньше. Тут можно вспомнить, например, подделку документов или их частей — подписей, печатей, самого текста и прочего. Конечно, используемые технологии были проще по уровню, чем существующие генеративные сети. Но тем не менее позволяли мошенникам добиваться своих целей. Сами по себе нейросети и ИИ в целом — лишь инструмент. С их развитием будет появляться всё больше методов и у киберпреступников. И эти методы тоже будут совершенствоваться, а входные требования для использования — снижаться. Сейчас сложно сказать, как именно будут использоваться эти инструменты, так как фантазия людей поистине безгранична. Но предположу, что двигаться всё будет в сторону создания более достоверных генераций контента. Который затем будет использоваться для извлечения киберпреступниками выгоды. При этом контентом может стать абсолютно всё — аудио, изображения (как людей, так и документов и вообще чего угодно), видео (к примеру, чтобы выдать себя за другое лицо в процессе верификации по видеозвонку), текст (например, для симуляции диалога с условной службой поддержки или создания релевантных получателю фишинговых писем).»

Людмила Богатырёва

руководитель департамента цифровых решений агентства "Полилог"

«С появлением более совершенных генеративных ИИ киберпреступникам удалось обмануть некоторые антивирусные и антиспам–программы. Например, фишинговые электронные письма, сгенерированные ИИ, легче проходят фильтры, а люди открывают их ссылки гораздо чаще. Также с помощью генеративных ИИ киберпреступники научились обходить защиту против ботов и даже подбирать пароли. Есть примеры использования ИИ в ботнете — сети компьютеров с вредоносным ПО, которое позволяет удалённо управлять заражёнными устройствами. С помощью ботнетов киберпреступники способны подменять пользователей, устраивать DDoS–атаки и проч. Однако для массивной атаки на тысячу и более устройств необходимо одновременно управлять большим количеством задач, что не под силу человеку. Поэтому всё чаще именно ИИ отвечает за центр контроля и управления. Последнее время подобные системы создаются с применением вычислительных мощностей умной техники, входящей в интернет вещей (IoT).»

Валентин Крохин

директор по продуктовому развитию ГК “Солар”.

«Искусственный интеллект стал инструментом мошенников буквально недавно, при этом он сильно расширил их возможности. Прежде всего это касается копирования голоса, вы не отличите голос родственника или вашего менеджера банка, или руководителя от сгенерированного ИИ. Также с помощью нейросетей можно составлять более изощренные варианты общения и текстов для вымогания денег. Бороться с этим можно только повышением внимания, например при любом подозрении говорить: “Я вам сейчас сам перезвоню”. Если это мошенники, то “оригинал” про это не знает»

Андрей Арефьев

директор по инновационным проектам ГК InfoWatch

«Когда речь идет о мошенниках, мы часто представляем человека, который звонит по телефону и вымогает деньги, либо на улице пытается кого-то обмануть. Когда мы говорим о корпоративном мошенничестве, ситуация совершенно иная: речь идет о человеке, который, работая в компании, хочет извлекать из этого дополнительную прибыль. В этой ситуации системы информационной безопасности с внедренным в них элементов машинного обучения (ML) и искусственного интеллекта позволяют эффективно поддерживать политику безопасности компании и за счет этого своевременно выявлять и пресекать мошеннические действия»

Источники: rskrf.ru, zatosvetly.gosuslugi.ru, kp.ru, ai.gov.ru

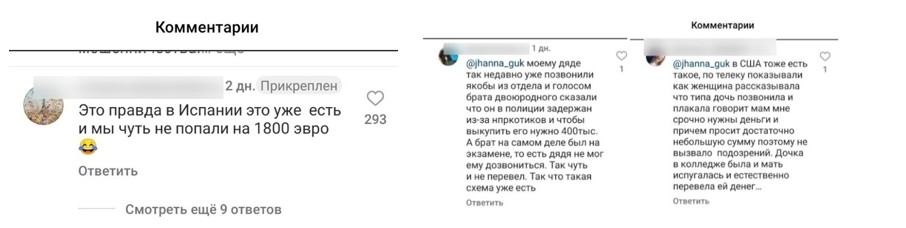

- Комментарии

Загрузка комментариев...